تاریخچه هوش مصنوعی + از ابتدا تاکنون

هوش مصنوعی را میتوان جزو آن دسته از اسامی دانست که این روزها بسیار به گوشمان میخورد. اما متاسفانه اغلب مردم با منشا آن آشنایی نداشته و نمیدانند که سرآغاز این فناوری از کجا بود. متاسفانه برخی هم آن را به داستانهای علمی-تخیلی یا باورهای نادرست ربط میدهند. همین عامل هم ابهامات را بیشتر میکند. ما در این مقاله میکوشیم تا به تاریخچه هوش مصنوعی پرداخته و تمام جنبههای آن را خدمت شما عزیزان شرح دهیم. شکی نیست که این موضوع میتواند دیدگاه بهتری برایتان ایجاد کرده و بیشتر با این فناوری کلیدی آشنا شوید.

هوش مصنوعی چیست؟ مروری بر ماهیت آن

تصور کنید ربات یا سیستمی باشد که بتواند با شما گفتوگو کرده، احساساتتان را درک کند و حتی برایتان شعر بگوید. یا ماشینی که بدون نیاز به راننده، شما را به مقصد برساند. چنین ایدههایی تا چند دهه پیش، فقط در داستانهای علمی-تخیلی مطرح بودند. اما حالا هوش مصنوعی این مفاهیم را به واقعیت تبدیل کرده است.

قبل از اینکه به سراغ تاریخچه هوش مصنوعی برویم، بهتر است ابتدا به ماهیت آن بپردازیم. چراکه درک درست از چیستی آن، باعث میشود نگاه عمیقتری به این حوزه داشته باشیم. هوش مصنوعی به زبان ساده، شبیهسازی تواناییهای انسانی در ماشینهاست. یعنی سیستمهایی که میتوانند یاد گرفته، استدلال کنند و تصمیم بگیرند. این ماشینها قادرند دادهها را پردازش کرده، الگوها را بشناسند و بر اساس آنها عمل کنند.

اما آیا هوش مصنوعی فقط تقلید از هوش انسانی است؟ نه دقیقاً. در برخی زمینهها حتی فراتر از تواناییهای ما عمل میکند. مثلاً در شناسایی الگوهای پیچیده در دادههای بزرگ، میتواند بهتر از هر انسانی عمل کند. همین ویژگی باعث شده تا در پزشکی، اقتصاد، هنر و حتی روابط اجتماعی نقش مهمی ایفا کند.

نکته مهم این است که هوش مصنوعی تنها یک فناوری نیست، بلکه یک مفهوم گسترده است. از الگوریتمهای ساده گرفته تا سیستمهای پیشرفتهای که میتوانند متون را تولید کرده یا تصاویر جدید خلق کنند. در واقع، هوش مصنوعی بیشتر شبیه یک ابزار است که بسته به نوع استفاده، میتواند بسیار مفید یا حتی چالشبرانگیز باشد.

سازنده هوش مصنوعی کیست؟

وقتی صحبت از هوش مصنوعی میشود، بسیاری تصور میکنند که این فناوری محصول ذهن یک فرد خاص است. اما واقعیت پیچیدهتر از این حرفهاست. هوش مصنوعی نتیجهی دههها تحقیق، تلاش و همکاری میان دانشمندان، مهندسان و محققان مختلف است. این فناوری بهمرور تکامل یافته و هر نسل، مفاهیم و مدلهای جدیدی به آن اضافه کرده است. بنابراین، نمیتوان تنها یک نفر را بهعنوان “سازندهی هوش مصنوعی” معرفی کرد.

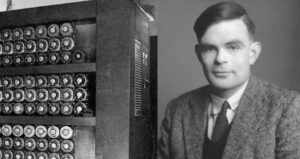

اگر بخواهیم به اولین ایدههای مرتبط با هوش مصنوعی برگردیم، باید از آلن تورینگ نام ببریم. این ریاضیدان و دانشمند کامپیوتر، در دههی ۱۹۵۰ ایدهی اینکه “آیا ماشینها میتوانند فکر کنند؟” را مطرح کرد. او آزمایشی معروف به نام آزمون تورینگ را پیشنهاد داد که معیاری برای سنجش هوش مصنوعی محسوب میشود. هرچند تورینگ خودش یک سیستم هوش مصنوعی نساخت، اما پایههای نظری این فناوری را بنا گذاشت.

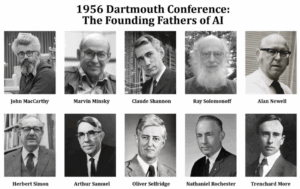

در دههی ۱۹۵۰ و ۱۹۶۰، دانشمندانی مانند جان مککارتی، ماروین مینسکی، هربرت سایمون و آلن نیوول نقش کلیدی در توسعهی این حوزه داشتند. جان مککارتی کسی بود که اصطلاح “هوش مصنوعی” (Artificial Intelligence) را ابداع کرد. او در سال ۱۹۵۶، کنفرانس دارتموث را برگزار کرد که نقطهی شروع رسمی این حوزه بهشمار میرود. مککارتی همچنین زبان برنامهنویسی LISP را توسعه داد که در آن زمان برای ساخت سیستمهای هوش مصنوعی استفاده میشد.

در دهههای بعد، هوش مصنوعی با ظهور شبکههای عصبی مصنوعی، یادگیری ماشین و یادگیری عمیق، پیشرفت زیادی کرد. افرادی مانند جفری هینتون، یان لیکان و یوشوا بنجیو که به “پدران یادگیری عمیق” معروفاند، کمک بزرگی به پیشرفت هوش مصنوعی مدرن کردند. آنها نشان دادند که میتوان از مدلهای شبکه عصبی برای یادگیری و پردازش دادههای پیچیده استفاده کرد. این کار باعث شد که تکنیکهایی مانند تشخیص تصویر، پردازش زبان طبیعی و حتی خودروهای خودران به واقعیت نزدیکتر شوند.

در سالهای اخیر، شرکتهایی مانند OpenAI، گوگل دیپمایند، تسلا و مایکروسافت نقش مهمی در توسعهی هوش مصنوعی داشتهاند. مدلهایی مانند GPT-4، DALL·E و AlphaGo توسط تیمهای تحقیقاتی بزرگی ساخته شدهاند که متشکل از صدها دانشمند، مهندس و متخصص داده هستند. بنابراین، نمیتوان یک فرد خاص را “سازندهی هوش مصنوعی” نامید. بلکه این فناوری محصول همکاری جهانی و دهها سال تلاش بیوقفهی متخصصان مختلف است.

به طور کلی هوش مصنوعی مانند یک پروژهی عظیم می باشد که نسل به نسل تکامل یافته و همچنان در حال پیشرفت است. اگرچه افراد خاصی در تاریخ آن نقش کلیدی داشتهاند، اما توسعهی آن نتیجهی تلاش جمعی صدها هزار نفر در سراسر جهان بوده و این مسیر، هنوز به پایان نرسیده است!

تاریخچه کامل هوش مصنوعی

بیشتر افراد تصور دقیقی از تاریخچه هوش مصنوعی ندارند. برخی فکر میکنند این فناوری یک پدیده مدرن است که در همین یکی دو دهه اخیر متولد شده. برخی دیگر هم تصورات نادرستی دارند که تحت تأثیر ادعاهای اغراقشده در شبکههای اجتماعی شکل گرفته است. این اطلاعات نادرست باعث میشود که بسیاری از افراد برداشتهای اشتباهی درباره منشأ و تکامل این فناوری داشته باشند. اما حقیقت این است که ایدههای مرتبط با هوش مصنوعی، قدمتی طولانی دارند و در طول تاریخ، مسیر پرفراز و نشیبی را طی کردهاند. ما در این مقاله قصد داریم تا بهصورت دقیق و مرحلهبهمرحله، این تاریخچه را مرور کنیم.

۱. شکلگیری ایدهها (از دوران باستان تا اوایل قرن ۲۰)

ایده هوش مصنوعی بهظاهر یک مفهوم مدرن است، اما ریشههای آن را میتوان در اعماق تاریخ بشری جستوجو کرد. از زمانی که انسانها توانستند داستان بنویسند، رویاهایشان را درباره موجوداتی که قدرت تفکر و تصمیمگیری دارند، به تصویر کشیدند. در این بخش به بررسی نخستین ایدهها و تخیلاتی میپردازیم که پایهگذار مفهوم امروزی هوش مصنوعی شدند.

۱.۱. اسطورهها و رویاهای باستانی

اگر به اسطورههای یونان و مصر باستان نگاهی بیندازیم، متوجه میشویم که انسان همیشه رؤیای خلق موجوداتی شبیه خود را در سر داشته است. در افسانههای یونانی، “تالوس”، یک غول برنزی بود که توسط هفایستوس، خدای آهنگری، ساخته شد و میتوانست از کرت محافظت کند. در مصر باستان هم مجسمههایی وجود داشت که تصور میشد روح زندگی در آنها دمیده شده است. این نمونهها نشان میدهد که ایده موجودات مصنوعی با هوش مستقل، از دیرباز در ذهن بشر وجود داشته است.

۱.۲. ماشینهای خودکار در دوران باستان و قرون وسطی

با پیشرفت علم و فناوری، انسانها کمکم تلاش کردند تا این رویاها را به واقعیت تبدیل کنند. در قرن سوم پیش از میلاد، مهندس یونانی، “فیلو بیزانسی”، دستگاههایی را طراحی کرد که میتوانستند بهطور خودکار حرکت کنند. بعدها در دوران اسلامی، دانشمندانی مانند “الجزری” دستگاههای مکانیکی پیچیدهای را ابداع کردند که برخی از آنها عملکردی شبیه به روباتهای اولیه داشتند.

۱.۳. دوران رنسانس و اولین مفاهیم علمی هوش مصنوعی

در دوران رنسانس، دانشمندان اروپایی علاقه زیادی به ایده ماشینهای خودکار پیدا کردند. “لئوناردو داوینچی” در قرن پانزدهم، طرحهایی از یک شوالیه مکانیکی کشید که میتوانست حرکت کند. همچنین در قرن هفدهم، “رنه دکارت” و “گاتفرید لایبنیتز” این ایده را مطرح کردند که شاید تفکر انسان نیز بر اساس قوانین ریاضی و مکانیکی قابل شبیهسازی باشد. این دیدگاه، سنگ بنای اصلی فلسفهای شد که بعدها در علوم رایانه و هوش مصنوعی مورد استفاده قرار گرفت.

۱.۴. ریاضیات و منطق در قرون ۱۸ و ۱۹

در قرن هجدهم، دانشمندان تلاش کردند تا منطق انسانی را در قالب فرمولهای ریاضی بیان کنند. “جورج بول”، ریاضیدان انگلیسی، در قرن نوزدهم سیستم “جبر بولی” را توسعه داد که بعدها بهعنوان پایهای برای برنامهنویسی کامپیوترها و هوش مصنوعی استفاده شد. در همین دوران، “چارلز بابیج” و “آدا لاولیس” طرحهایی برای نخستین ماشین محاسباتی ارائه دادند که از دید بسیاری، اولین قدم بهسوی کامپیوترهای امروزی بود.

۲. آغاز هوش مصنوعی مدرن (۱۹۰۰ تا ۱۹۵۰)

با ورود به قرن بیستم، علم و فناوری به سطحی رسید که ایدههای مربوط به هوش مصنوعی دیگر صرفاً در حد افسانه یا فلسفه نبودند. دانشمندان شروع به بررسی روشهایی کردند که بتوانند تفکر و یادگیری انسانی را بهصورت علمی مدلسازی کنند. در این دوره، چندین پیشرفت کلیدی در ریاضیات، منطق و علوم کامپیوتر، پایههای اولیه هوش مصنوعی مدرن را شکل دادند.

۲.۱. تأثیر منطق ریاضی و محاسبات

در اوایل قرن بیستم، منطقدانان بزرگی مانند “کورت گودل”، “آلن تورینگ” و “آلونزو چرچ” تحقیقات مهمی در زمینه محاسبات و منطق انجام دادند. تورینگ در سال ۱۹۳۶، مفهوم “ماشین تورینگ” را معرفی کرد که نشان داد هر مسئلهای که از لحاظ محاسباتی قابلحل باشد، میتواند توسط یک ماشین حل شود. این ایده پایه و اساس علوم کامپیوتر شد.

۲.۲. جنگ جهانی دوم و نقش رمزنگاری

در طول جنگ جهانی دوم، آلن تورینگ و دیگر دانشمندان، روی ماشینهایی کار کردند که قادر به شکستن رمزهای پیچیده آلمانیها بودند. این تحقیقات، نهتنها در پیروزی متفقین نقش داشت، بلکه زمینهساز پیشرفتهای بزرگی در علوم کامپیوتر شد. یکی از نتایج این تلاشها، ساخت “کالیبرن”، یکی از نخستین کامپیوترهای برنامهپذیر بود.

۲.۳. ظهور نخستین کامپیوترهای دیجیتال

با پایان جنگ، دانشمندان به این نتیجه رسیدند که کامپیوترها میتوانند فراتر از محاسبات عددی عمل کنند. پروژههایی مانند “ENIAC” و “EDVAC” آغازگر عصری بودند که در آن ماشینها میتوانستند دادهها را ذخیره و برنامههای پیچیده را اجرا کنند. این پیشرفتها باعث شد ایدههای مربوط به شبیهسازی هوش انسانی، از تئوری به مرحله اجرا نزدیکتر شوند.

۲.۴. پرسشهای فلسفی درباره هوش مصنوعی

در این دوره، بحثهای فلسفی درباره امکان ایجاد یک “ذهن مصنوعی” شدت گرفت. یکی از مهمترین سؤالات این بود: آیا یک ماشین میتواند مانند یک انسان فکر کند؟ آلن تورینگ در سال ۱۹۵۰، مقاله معروف خود را با عنوان “محاسبات ماشینی و هوش” منتشر کرد. او در این مقاله “آزمون تورینگ” را پیشنهاد داد که هنوز هم یکی از مهمترین معیارها برای سنجش هوش مصنوعی محسوب میشود.

۳. طلوع هوش مصنوعی (۱۹۵۰ تا ۱۹۷۰)

دهه ۱۹۵۰، نقطه عطفی در تاریخ هوش مصنوعی بود. در این دوران، دانشمندان از مرحله نظری عبور کردند و اولین برنامههای هوشمند را توسعه دادند. این دوره، زمان ظهور اولین الگوریتمهای یادگیری، پردازش زبان طبیعی و سیستمهای خبره بود.

۳.۱. تولد رسمی هوش مصنوعی

اصطلاح “هوش مصنوعی” برای اولین بار در سال ۱۹۵۶ در یک کنفرانس علمی در “دارتموث” مطرح شد. این کنفرانس که توسط “جان مککارتی”، “ماروین مینسکی” و دیگر دانشمندان برجسته برگزار شد، بهعنوان لحظهای تاریخی در این حوزه شناخته میشود. در این نشست، دانشمندان بر این باور بودند که میتوان با استفاده از الگوریتمها و دادهها، ماشینهایی ساخت که مانند انسانها بیندیشند.

۳.۲. اولین برنامههای هوشمند

در همین سالها، نخستین برنامههای هوش مصنوعی ساخته شدند. یکی از اولین آنها “Logic Theorist” بود که توانست برخی از قضایای ریاضی را اثبات کند. در سال ۱۹۵۷، “فرانک روزنبلات” شبکه عصبی “پرسیپترون” را معرفی کرد که قادر به یادگیری بود. این شبکههای عصبی، پایهای برای هوش مصنوعی مدرن شدند.

۳.۳. پیشرفت در زبانهای برنامهنویسی

یکی از موانع اصلی توسعه هوش مصنوعی، نبود زبانهای برنامهنویسی مناسب بود. در سال ۱۹۵۸، جان مککارتی زبان “LISP” را توسعه داد که مخصوص برنامهنویسی هوش مصنوعی طراحی شده بود. این زبان، نقش کلیدی در توسعه سیستمهای هوشمند ایفا کرد.

۳.۴. اولین رؤیاهای بزرگ و چالشهای اولیه

در دهه ۱۹۶۰، بسیاری از محققان معتقد بودند که تا چند سال آینده، کامپیوترها میتوانند مانند انسان فکر کنند. اما بهمرور مشخص شد که توسعه هوش مصنوعی سختتر از آن چیزی است که تصور می کردند. کامپیوترهای آن زمان قدرت پردازشی محدودی داشتند و دادههای کافی برای یادگیری در دسترس نبود. بااینحال، امیدواریها همچنان ادامه داشت و تحقیقات بیشتری در این زمینه انجام شد.

۴. دوران رکود هوش مصنوعی (۱۹۷۰ تا ۱۹۸۰)

پس از امیدهای بزرگی که در دهه ۱۹۵۰ و ۱۹۶۰ شکل گرفت، دهه ۱۹۷۰ با ناامیدیهای زیادی همراه شد. محققان دریافتند که بسیاری از مشکلات هوش مصنوعی، پیچیدهتر از آن هستند که تصور میشد. در این دوره، پیشرفتهای این حوزه بهکندی پیش رفت و بسیاری از پروژههای تحقیقاتی متوقف شدند.

۴.۱. دلیل اصلی رکود: انتظارات غیرواقعی

در دهههای قبل، دانشمندان تصور میکردند که میتوانند بهسرعت سیستمهایی را توسعه دهند که مانند انسان فکر کنند. اما در عمل، کامپیوترهای آن زمان قدرت پردازش کافی برای اجرای الگوریتمهای پیچیده را نداشتند. علاوه بر این، یادگیری ماشین هنوز در مراحل ابتدایی خود بود و حجم دادههای در دسترس بسیار محدود بود.

۴.۲. کاهش سرمایهگذاریها و تعطیلی پروژهها

با مشخص شدن محدودیتهای فناوری، دولتها و شرکتهای بزرگ که تا آن زمان سرمایهگذاریهای کلانی روی هوش مصنوعی کرده بودند، بهتدریج حمایت خود را کاهش دادند. پروژههای بزرگی مانند “ترجمه ماشینی” که در دهه ۱۹۶۰ آغاز شده بود، به دلیل نتایج ضعیف، متوقف شد. حتی وزارت دفاع آمریکا که یکی از مهمترین حامیان تحقیقات هوش مصنوعی بود، سرمایهگذاریهای خود را کاهش داد.

۴.۳. رشد سیستمهای خبره بهعنوان جایگزین

با اینکه هوش مصنوعی عمومی با چالشهای بزرگی روبهرو شد، برخی از محققان تمرکز خود را روی سیستمهای محدودتر و خاصتر گذاشتند. یکی از این سیستمها، “سیستمهای خبره” بودند که میتوانستند در حوزههای خاص مانند پزشکی یا مهندسی، تصمیمگیری کنند. یکی از نمونههای موفق آن، سیستم “MYCIN” بود که برای تشخیص بیماریهای خونی توسعه داده شد.

۴.۴. پیشرفتهای محدود اما مهم

هرچند این دوره بهعنوان “زمستان هوش مصنوعی” شناخته میشود، اما برخی از تحقیقات همچنان ادامه داشتند. بهبود در زبانهای برنامهنویسی، توسعه الگوریتمهای جدید و مطالعات روی شبکههای عصبی، زمینه را برای پیشرفتهای آینده فراهم کرد. اما بهطور کلی، هوش مصنوعی دیگر مانند دهه ۱۹۵۰ و ۱۹۶۰، در مرکز توجه نبود.

۵. بازگشت هوش مصنوعی و سیستمهای خبره (۱۹۸۰ تا ۱۹۹۰)

با ورود به دهه ۱۹۸۰، هوش مصنوعی دوباره مورد توجه قرار گرفت. پیشرفت در سختافزارهای کامپیوتری و موفقیت سیستمهای خبره، باعث شد که شرکتها و دانشگاهها بار دیگر به سرمایهگذاری در این حوزه علاقهمند شوند.

۵.۱. ظهور دوباره سیستمهای خبره

سیستمهای خبره، که در دهه قبل توسعه پیدا کرده بودند، در این دهه به اوج خود رسیدند. شرکتهای بزرگ مانند “زیراکس” و “دیجیتال” از این سیستمها برای بهبود تصمیمگیری در صنایع خود استفاده کردند. این سیستمها بهویژه در پزشکی و تشخیص بیماریها کاربرد زیادی داشتند.

۵.۲. پیشرفت در سختافزار و محاسبات

یکی از مهمترین عوامل رشد هوش مصنوعی در این دوره، پیشرفت در سختافزار کامپیوترها بود. پردازندههای قویتر و حافظههای بهتر، امکان اجرای الگوریتمهای پیچیدهتر را فراهم کردند. همچنین، برخی از شرکتها مانند “IBM” کامپیوترهایی را توسعه دادند که بهطور خاص برای پردازشهای هوش مصنوعی طراحی شده بودند.

۵.۳. ورود هوش مصنوعی به صنعت و تجارت

در دهه ۱۹۸۰، شرکتهای تجاری به استفاده از هوش مصنوعی علاقهمند شدند. سیستمهای خبره در حوزههایی مانند تشخیص عیب در کارخانهها، تحلیل بازارهای مالی و برنامهریزی تولید مورد استفاده قرار گرفتند. دولتهای مختلف نیز پروژههایی را برای توسعه هوش مصنوعی راهاندازی کردند.

۵.۴. سقوط دوباره در اواخر دهه ۱۹۸۰

هرچند سیستمهای خبره موفقیتهایی داشتند، اما در اواخر دهه ۱۹۸۰ مشکلات جدیدی پدیدار شد. هزینههای بالای توسعه و نگهداری این سیستمها باعث شد که بسیاری از شرکتها از ادامه سرمایهگذاری منصرف شوند. علاوه بر این، سیستمهای خبره قابلیت یادگیری نداشتند و بهسختی میتوانستند با تغییرات جدید سازگار شوند. این مسائل باعث شد که در پایان این دهه، دوباره نوعی رکود در هوش مصنوعی ایجاد شود و بسیاری از پروژههای بلندپروازانه متوقف شوند.

۶. آغاز یادگیری ماشین و شبکههای عصبی (۱۹۹۰ تا ۲۰۰۰)

پس از رکود اواخر دهه ۱۹۸۰، دهه ۱۹۹۰ را میتوان دوران بازگشت تدریجی هوش مصنوعی دانست. در این دوره، پیشرفت در الگوریتمهای یادگیری ماشین و پردازش دادهها باعث شد که هوش مصنوعی از سیستمهای خبره سنتی فاصله بگیرد و به سمت روشهای جدیدی حرکت کند.

۶.۱. احیای شبکههای عصبی مصنوعی

شبکههای عصبی که در دهه ۱۹۵۰ معرفی شده بودند، به دلیل محدودیتهای سختافزاری و مشکلات ریاضیاتی، در دهههای قبل چندان مورد توجه قرار نگرفتند. اما در دهه ۱۹۹۰، با پیشرفت در روشهای بهینهسازی و افزایش توان پردازشی کامپیوترها، این مدلها دوباره احیا شدند. روشهای جدیدی مانند “پسانتشار خطا” (Backpropagation) امکان آموزش بهتر شبکههای عصبی را فراهم کردند و باعث شدند که هوش مصنوعی در برخی از مسائل پیچیده موفق عمل کند.

۶.۲. رشد الگوریتمهای یادگیری ماشین

در این دوره، یادگیری ماشین بهعنوان شاخهای از هوش مصنوعی توسعه پیدا کرد. بهجای تکیه بر قوانین از پیش تعیینشده، سیستمها شروع به یادگیری از دادهها کردند. الگوریتمهایی مانند “درختهای تصمیم”، “ماشینهای بردار پشتیبان” (SVM) و “بیز ساده” بهطور گسترده برای مسائل طبقهبندی و پیشبینی مورد استفاده قرار گرفتند. این روشها باعث شدند که هوش مصنوعی کاربردهای گستردهتری پیدا کند.

۶.۳. ورود هوش مصنوعی به دنیای عملی

در این دوره، بسیاری از شرکتهای فناوری به استفاده از هوش مصنوعی در محصولات خود علاقهمند شدند. موتورهای جستجو مانند “گوگل” و “یاهو” از الگوریتمهای یادگیری ماشین برای بهبود نتایج جستجو استفاده کردند. سیستمهای تشخیص گفتار نیز بهطور قابل توجهی بهبود یافتند و در محصولاتی مانند “Dragon NaturallySpeaking” بهکار گرفته شدند.

۶.۴. موفقیت در بازیهای کامپیوتری و رقابت با انسان

یکی از مهمترین نقاط عطف این دهه، شکست “گری کاسپاروف”، قهرمان شطرنج جهان، توسط کامپیوتر “دیپ بلو” (Deep Blue) در سال ۱۹۹۷ بود. این اتفاق نشان داد که کامپیوترها میتوانند در برخی از حوزهها به سطحی برسند که حتی از انسان هم برتر باشند. این پیروزی تأثیر بزرگی در جلب توجه دوباره به هوش مصنوعی داشت و باعث افزایش سرمایهگذاریها در این حوزه شد.

۷. ظهور دادههای بزرگ و یادگیری عمیق (۲۰۰۰ تا ۲۰۱۰)

در دهه ۲۰۰۰، حجم عظیمی از دادهها در دسترس قرار گرفت. اینترنت، شبکههای اجتماعی و رشد ابزارهای دیجیتال باعث شدند که دانشمندان بتوانند از دادههای بسیار بیشتری برای آموزش الگوریتمهای هوش مصنوعی استفاده کنند. این امر زمینهساز تحولات بزرگی در این حوزه شد.

۷.۱. انقلاب دادههای بزرگ

یکی از بزرگترین تغییرات این دوره، افزایش شدید حجم دادهها بود. با رشد شبکههای اجتماعی مانند “فیسبوک” و “توییتر”، موتورهای جستجو مانند “گوگل” ، حجم عظیمی از دادههای کاربران تولید شد. این دادهها به محققان کمک کردند که الگوریتمهای یادگیری ماشین را با دقت بیشتری آموزش دهند.

۷.۲. پیشرفت در پردازش و سختافزار

در این دوره، پردازندههای گرافیکی (GPU) نقش مهمی در پیشرفت هوش مصنوعی ایفا کردند. برخلاف پردازندههای سنتی (CPU)، پردازندههای گرافیکی قادر بودند حجم عظیمی از محاسبات را بهطور همزمان پردازش کنند. این ویژگی باعث شد که شبکههای عصبی عمیق (Deep Neural Networks) بهطور مؤثرتری اجرا شوند.

۷.۳. یادگیری عمیق و انقلاب در هوش مصنوعی

در اواخر دهه ۲۰۰۰، محققان متوجه شدند که شبکههای عصبی عمیق میتوانند عملکردی بسیار بهتر از مدلهای سنتی داشته باشند. الگوریتمهایی مانند “شبکههای پیچشی” (CNN) برای پردازش تصاویر و “شبکههای بازگشتی” (RNN) برای پردازش زبان طبیعی توسعه یافتند. این تکنیکها باعث شدند که سیستمهای تشخیص تصویر، ترجمه ماشینی و پردازش زبان طبیعی، با دقت بیسابقهای عمل کنند.

۷.۴. موفقیت در رقابتهای جهانی و کاربردهای گسترده

یکی از نقاط عطف این دوره، پیروزی “الکسنت” (AlexNet) در سال ۲۰۱۲ در مسابقه “ImageNet” بود. این شبکه عصبی توانست دقت تشخیص تصویر را به میزان قابل توجهی بهبود بخشد. علاوه بر این، شرکتهای بزرگ مانند “گوگل”، “مایکروسافت” و “آمازون” شروع به سرمایهگذاری جدی در یادگیری عمیق کرده و از آن در محصولات خود استفاده کردند.

۸. پیشرفتهای شگرف در یادگیری عمیق و پردازش زبان طبیعی (۲۰۱۰ تا ۲۰۲۰)

دهه ۲۰۱۰ را میتوان نقطهی عطفی در تاریخ هوش مصنوعی دانست. در این دوره، یادگیری عمیق (Deep Learning) به شکلی گسترده مورد استفاده قرار گرفت و باعث پیشرفتهای خیرهکنندهای در حوزههای پردازش تصویر، پردازش زبان طبیعی (NLP) و سیستمهای تصمیمگیری شد.

۸.۱. پیشرفت چشمگیر در تشخیص تصویر و ویدیو

در این دهه، شبکههای عصبی پیچشی (CNN) به سطحی رسیدند که دقت آنها در تشخیص تصویر از انسان هم فراتر رفت. مدلهایی مانند ResNet و EfficientNet بهبود چشمگیری در درک بصری ایجاد کردند. سیستمهای هوش مصنوعی در پزشکی برای تشخیص بیماریهایی مانند سرطان، در صنعت خودرو برای خودروهای خودران، و در شبکههای اجتماعی برای تشخیص محتوای نامناسب بهکار گرفته شدند.

۸.۲. انقلاب در پردازش زبان طبیعی (NLP)

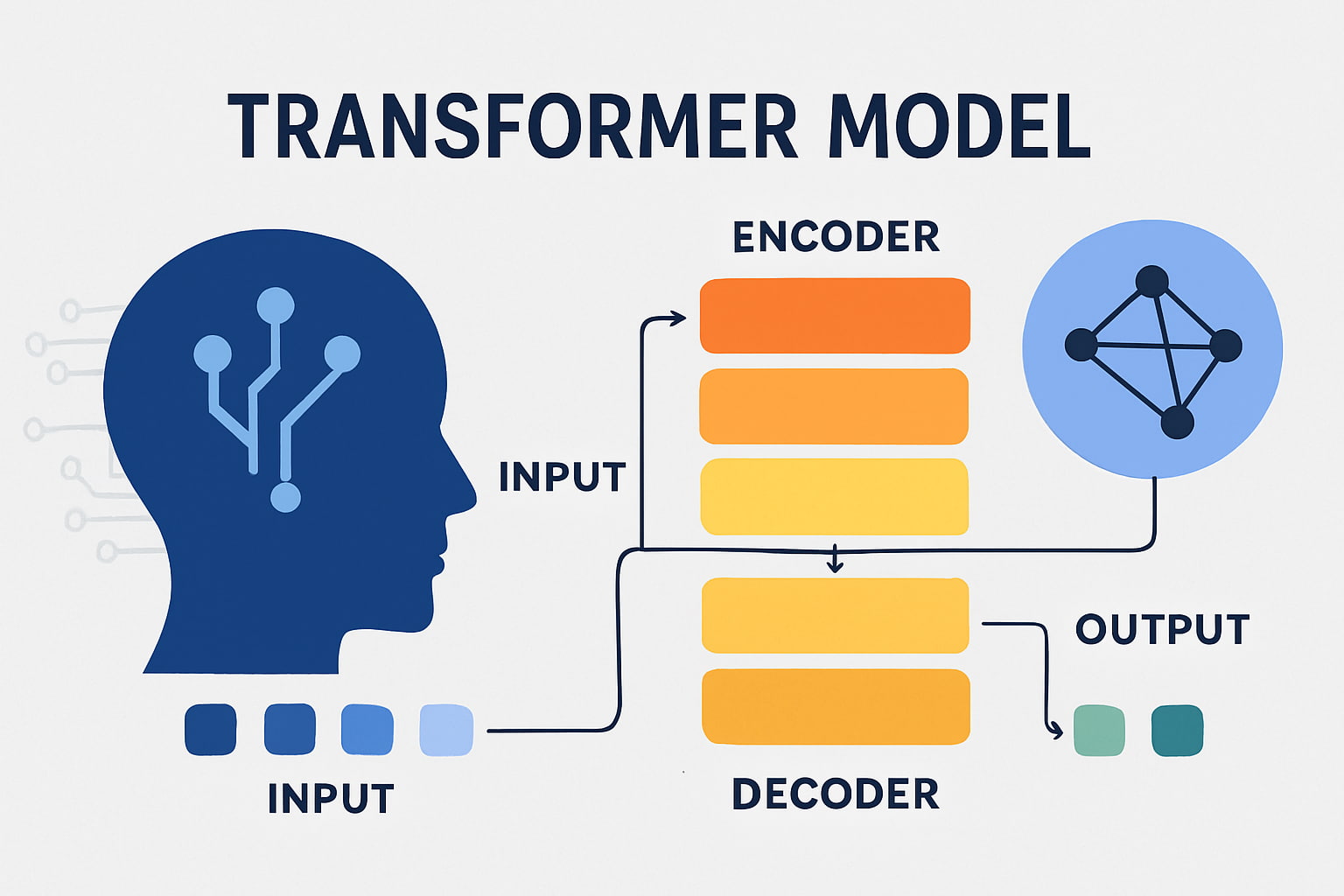

یکی از بزرگترین موفقیتهای این دهه، توسعهی مدلهای زبانی قدرتمند مانند ترنسفورمرها (Transformers) بود. مدلهایی مانند BERT (ساختهی گوگل) و GPT (توسعهی OpenAI) باعث شدند که سیستمهای هوش مصنوعی بتوانند متن را بهطور دقیقتری درک کنند. چتباتها و دستیارهای صوتی مانند سیری، الکسا و گوگل اسیستنت به کمک این مدلها پیشرفت زیادی داشتند.

۸.۳. نقش یادگیری تقویتی در پیشرفت هوش مصنوعی

یادگیری تقویتی (Reinforcement Learning) که به هوش مصنوعی امکان یادگیری از طریق آزمون و خطا را میدهد، در این دهه پیشرفت بزرگی داشت. DeepMind با توسعهی AlphaGo در سال ۲۰۱۶، توانست قهرمان جهانی بازی Go را شکست دهد، که این اتفاق یک دستاورد تاریخی برای هوش مصنوعی محسوب میشد. پس از آن، AlphaZero معرفی شد که بدون نیاز به دادههای انسانی، تنها از طریق یادگیری از خود توانست مهارتهای برتری در بازیهایی مانند شطرنج، گو و شوگی کسب کند.

۸.۴. کاربردهای گسترده در صنعت و زندگی روزمره

هوش مصنوعی در این دوره بهطور گسترده در حوزههایی مانند تشخیص گفتار، پردازش تصویر، ترجمه ماشینی، پزشکی، تجارت الکترونیک و امنیت سایبری مورد استفاده قرار گرفت. شرکتهای بزرگی مانند گوگل، فیسبوک، تسلا، مایکروسافت و آمازون سرمایهگذاری عظیمی روی این فناوری انجام دادند. خودروهای خودران، سیستمهای پیشنهاددهندهی هوشمند و هوش مصنوعی در مدیریت دادهها، همگی از پیشرفتهای مهم این دوره بودند.

۹. ورود به عصر هوش مصنوعی مولد و چتباتهای هوشمند (۲۰۲۰ تا ۲۰۲۴)

با ورود به دهه ۲۰۲۰، هوش مصنوعی به مرحلهای رسید که توانست محتوا تولید کند. از تولید متن گرفته تا خلق تصاویر، موسیقی و حتی ویدیو، مدلهای هوش مصنوعی بیش از هر زمان دیگری شبیه به انسان عمل میکنند.

۹.۱. انقلاب در هوش مصنوعی مولد (Generative AI)

یکی از مهمترین اتفاقات این دوره، معرفی مدلهای هوش مصنوعی مولد مانند GPT-3 و GPT-4 (از OpenAI) و DALL·E برای تولید تصاویر بود. این مدلها توانستند متونی شبیه به نوشتههای انسان تولید کنند، تصاویر کاملاً جدید خلق کرده و حتی موسیقی بسازند. این پیشرفت باعث شد که هوش مصنوعی بتواند در خلق محتوای دیجیتال، طراحی، برنامهنویسی و حتی نوشتن مقالات علمی نقش مهمی ایفا کند.

۹.۲. پیشرفت چتباتها و مدلهای زبان بزرگ (LLMs)

در این دوره، چتباتهای هوشمند مانند ChatGPT، Claude و Bard به اوج کارایی خود رسیدند. این مدلها میتوانند مکالمات طبیعی داشته باشند، متن تولید کنند، کدنویسی انجام دهند و حتی به تحلیل دادهها بپردازند. اغلب شرکتها از این فناوری برای خدمات مشتریان، تولید محتوا، خودکارسازی کارهای اداری و بهینهسازی فرآیندهای صنعتی استفاده کردند.

۹.۳. پیشرفت هوش مصنوعی در حوزهی ویدیو و صدا

مدلهایی مانند Runway ML و Stable Diffusion امکان تولید ویدیوهای کاملاً جدید را تنها بر اساس متن فراهم کردند. در کنار آن، فناوریهای تبدیل متن به صدا (Text-to-Speech) مانند VALL-E توانستند صدای انسان را شبیهسازی کنند. این فناوریها باعث شدند که دوبلهی خودکار، تولید پادکست، و ایجاد شخصیتهای مجازی به سطحی بیسابقه برسد.

۹.۴. چالشهای اخلاقی و قانونی در هوش مصنوعی

با پیشرفت سریع هوش مصنوعی، نگرانیهایی دربارهی حقوق مالکیت معنوی، تولید اطلاعات جعلی، سوگیری الگوریتمها و خطرات احتمالی آن مطرح شد. دولتها و سازمانهای فناوری شروع به تدوین قوانین و سیاستهایی کردند تا استفاده از هوش مصنوعی در مسیر درست قرار گیرد. در عین حال، این فناوری همچنان با سرعت بالایی در حال گسترش است و به بخش جداییناپذیری از زندگی مدرن تبدیل شده است.

۱۰. آیندهی هوش مصنوعی و چالشهای پیش رو (۲۰۲۴ و پس از آن)

هوش مصنوعی تاکنون تحولات عظیمی را در زندگی بشر ایجاد کرده ، اما این تازه آغاز راه است. با پیشرفتهای سریع در این حوزه، سوالات زیادی دربارهی آیندهی آن مطرح میشود. آیا هوش مصنوعی به سطحی میرسد که از انسان هوشمندتر شود؟ آیا میتوان آن را کاملاً تحت کنترل نگه داشت؟ چالشها و فرصتهای پیش رو چیست؟

۱۰.۱. هوش مصنوعی عمومی (AGI)؛ واقعیت یا خیال؟

یکی از بحثبرانگیزترین موضوعات در حوزهی هوش مصنوعی، رسیدن به هوش مصنوعی عمومی (Artificial General Intelligence – AGI) است. AGI برخلاف مدلهای فعلی که تنها در حوزههای خاصی عملکرد دارند، میتواند مانند یک انسان در زمینههای مختلف فکر کرده، یاد بگیرد و تصمیمگیری کند. برخی از دانشمندان مانند “سم آلتمن” (مدیرعامل OpenAI) و “ایلان ماسک” معتقدند که AGI ممکن است تا چند دههی آینده به واقعیت تبدیل شود. در حالی که دیگران هشدار میدهند که این فناوری میتواند خطرات بزرگی برای بشریت داشته باشد.

۱۰.۲. تأثیر هوش مصنوعی بر مشاغل و اقتصاد

یکی از چالشهای مهم آینده، تأثیر گستردهی هوش مصنوعی بر بازار کار است. بسیاری از مشاغل، بهویژه آنهایی که روتین و تکراری هستند، بهطور کامل خودکار خواهند شد. از طرف دیگر، مشاغل جدیدی در زمینهی مهندسی هوش مصنوعی، مدیریت دادهها، امنیت سایبری و اخلاق هوش مصنوعی ایجاد خواهند شد. سوال اساسی این است که آیا جامعه میتواند خود را با این تغییرات بزرگ تطبیق دهد یا خیر.

۱۰.۳. اخلاق و کنترل هوش مصنوعی

با پیشرفت هوش مصنوعی، نگرانیهایی دربارهی حریم خصوصی، انتشار اطلاعات نادرست، و دستکاری افکار عمومی افزایش یافته است. برخی کشورها قوانین سختگیرانهای برای استفاده از این فناوری وضع کردهاند. سازمانهای فناوری نیز به دنبال توسعهی هوش مصنوعی اخلاقی و شفاف هستند تا اطمینان حاصل شود که این ابزارها به نفع جامعه استفاده میشوند.

۱۰.۴. آیندهی همکاری انسان و هوش مصنوعی

بسیاری از متخصصان بر این باورند که آیندهی هوش مصنوعی نه در جایگزینی انسان، بلکه در همکاری انسان و ماشین نهفته است. ابزارهای هوش مصنوعی میتوانند به پزشکان کمک کنند تا بیماریها را دقیقتر تشخیص دهند، به دانشمندان در کشف داروهای جدید کمک کرده و حتی به هنرمندان در خلق آثار هنری جدید یاری رسانند.

۱۰.۵. آیا باید از هوش مصنوعی بترسیم؟

بزرگترین سوالی که دربارهی آیندهی هوش مصنوعی مطرح میشود این است: آیا باید از آن بترسیم یا آن را بهعنوان یک فرصت ببینیم؟ برخی معتقدند که هوش مصنوعی، اگر بهدرستی مدیریت نشود، میتواند تهدیدی برای بشریت باشد. اما در عین حال، این فناوری میتواند باعث پیشرفتهای شگفتانگیز در پزشکی، علم، آموزش و صنعت شود. آینده به نحوهی استفادهی ما از این فناوری بستگی دارد.

سخن آخر

شکی نیست که شما هم تا به این لحظه به خوبی با تاریخچه هوش مصنوعی آشنا شده و دریافتهاید که این فناوری چگونه خود را به این جایگاه رسانده است. این مورد همان چیزی میباشد که به شما کمک میکند تا بتوانید دیدگاه بهتری نسبت به این فناوری منحصر به فرد داشته باشید. با این حال اگر هنوز سوال یا ابهامی در این رابطه دارید، میتوانید از طریق بخش نظرات با ما مطرح فرمایید.

چکیده

هوش مصنوعی یکی از بزرگترین تحولات دنیای فناوری می باشد که زندگی ما را دگرگون کرده است. اما واقعاً هوش مصنوعی چیست و چگونه به این مرحله رسیده است؟ برای پاسخ به این پرسش، ابتدا باید درک درستی از ماهیت آن داشته باشیم. هوش مصنوعی به زبان ساده، سیستمی است که میتواند یاد بگیرد، استدلال کرده و تصمیمگیری کند. یعنی درست مانند انسان، اما با استفاده از الگوریتمها و دادهها کار خود را انجام میدهد. این فناوری در طول سالها رشد کرده و از یک ایدهی علمی به یکی از مهمترین ابزارهای دنیای مدرن تبدیل شده است.

تاریخچهی هوش مصنوعی به دههی ۱۹۵۰ برمیگردد، زمانی که دانشمندانی مانند آلن تورینگ و جان مککارتی پایههای نظری این فناوری را بنا نهادند. از آن زمان تاکنون، این فناوری مراحل مختلفی را طی کرده است؛ از شبکههای عصبی و یادگیری ماشین گرفته تا مدلهای پیشرفتهی یادگیری عمیق. امروز، هوش مصنوعی در بخشهای مختلفی مانند پزشکی، صنعت، ارتباطات و حتی هنر حضور داشته و بهطور مداوم در حال پیشرفت است.

نمیتوان یک فرد خاص را بهعنوان “سازندهی هوش مصنوعی” معرفی کرد. این فناوری حاصل دههها تحقیق و تلاش مشترک دانشمندان، مهندسان و محققان مختلف در سراسر جهان است. شرکتهایی مانند OpenAI، گوگل دیپمایند و مایکروسافت نقش مهمی در توسعهی آن داشتهاند. مدلهایی مانند GPT-4، DALL·E و AlphaGo نمونههایی از پیشرفتهای شگفتانگیز در این حوزه هستند.

آیندهی هوش مصنوعی پر از فرصتها و چالشهاست. برخی معتقدند که این فناوری میتواند باعث پیشرفتهای بزرگی در علم و صنعت شود، در حالی که دیگران نگران تأثیرات آن بر بازار کار و امنیت اطلاعات هستند. اما واضح است، که هوش مصنوعی اینجاست تا بماند و مسیر زندگی بشر را برای همیشه تغییر دهد.

سوالات متداول

مقالات مشابه

هوش مصنوعی عمومی یا AGI چیست؟

1404/07/10

14 دقیقه

دادهکاوی یا Data Mining چیست؟

1404/07/08

14 دقیقه

پرامپت نویسی در هوش مصنوعی: هنر ارتباط با مدلهای زبانی

1404/07/06

18 دقیقه

خطرات مهم هوش مصنوعی برای بشر

1404/07/03

20 دقیقه

کلان داده چیست؟ آشنایی با بیگ دیتا (Big Data)

1404/07/01

19 دقیقه

اصطلاحات مهم هوش مصنوعی

1404/06/30

21 دقیقه

مدل ترنسفورمر (Transformer Model) چیست؟

1404/06/27

21 دقیقه

ترید با هوش مصنوعی

1404/06/24

15 دقیقه

هوش مصنوعی فارکس

1404/06/22

14 دقیقه

هوش مصنوعی روانشناس

1404/06/20

16 دقیقه

هوش مصنوعی برای یادگیری زبان

1404/06/17

14 دقیقه

دانلود اپلیکیشن

ارتقا سطح دانش و مهارت و کیفیت سبک زندگی با استفاده از هوش مصنوعی یک فرصت استثنایی برای انسان هاست.

ثبت دیدگاه

نظری موجود نمیباشد